¿Qué es el archivo robots.txt?

El archivo robots.txt es un archivo de texto simple que se utiliza para comunicar con los motores de búsqueda qué partes de un sitio web deben o no deben ser rastreadas. Este archivo es importante en la optimización para motores de búsqueda (SEO) ya que ayuda al propietario de una web a controlar el acceso de los robots de los motores de búsqueda a diferentes secciones de su sitio.

Para qué sirve el archivo robots.txt en SEO

En el ámbito del SEO, es necesario que los motores de búsqueda, como Google, rastreen nuestra web e indexen el contenido para mejorar su visibilidad en los resultados de búsqueda.

Sin embargo, no todo el contenido es igual de importante o relevante para ser rastreado e indexado. Aquí es donde entra en juego el archivo robots.txt, ya que permite a los propietarios de una web dirigir a los motores de búsqueda, indicando qué partes del sitio deben ser exploradas y cuáles deben ser ignoradas.

- Control de Acceso: Permite restringir el acceso a áreas sensibles o poco relevantes del sitio, como páginas de administración, paneles de usuario o secciones duplicadas.

- Optimización del Rastreo: Ayuda a los motores de búsqueda a centrarse en las partes más importantes del sitio, mejorando la eficiencia del rastreo y evitando el desperdicio de recursos en contenido innecesario.

- Prevención de Contenido Duplicado: Evita que los motores de búsqueda indexen contenido duplicado, lo que puede perjudicar el posicionamiento en los resultados de búsqueda.

Estructura básica del archivo robots.txt

El archivo robots.txt sigue una sintaxis sencilla que se compone de una o varias reglas. Cada regla indica a qué robots se aplica y qué se les permite o prohíbe hacer.

Directivas Comunes del robots.txt

- User-agent: Especifica a qué robot de motor de búsqueda se aplica la regla. Puede ser un robot específico (como Googlebot) o un comodín (*) para aplicarse a todos los robots.

- Disallow: Indica las rutas o páginas que no deben ser rastreadas por el robot especificado.

- Allow: (Opcional) Especifica las rutas que están permitidas para el robot, incluso si existe ya una regla general de prohibición podría aplicarse. Por defecto la directiva allow está activada con lo que los motores de búsqueda tendrán acceso a todo el site si no se indica lo contrario con un disallow.

- Sitemap: (Opcional) Proporciona la ubicación del archivo sitemap XML, que ayuda a los motores de búsqueda a entender la estructura del sitio y localizar las urls que lo componen.

Ejemplo de robots.txt

Este sería un ejemplo sencillo del código que hay que añadir a un archivo robots.txt:

User-agent: * Disallow: /admin/ Disallow: /login/ Allow: /public/ Sitemap: https://www.ejemplo.com/sitemap.xml

Y ahora la explicación sencilla 🙂

- La directiva User-agent: * se aplica a todos los robots.

- Las directivas Disallow impiden que los robots accedan a las carpetas /admin/ y /login/.

- La directiva Allow permite el acceso a la carpeta /public/.

- Se proporciona la ubicación del sitemap del sitio.

Cómo crear y subir un archivo robots.txt

Crear un archivo robots.txt es un proceso sencillo, pero debes seguir ciertos pasos para asegurarse de que funcione correctamente:

- Paso 1. Crea el archivo: utiliza un editor de texto sencillo, como el Bloc de Notas en Windows o TextEdit en macOS, para crear un archivo llamado robots.txt. No utilices formatos de texto enriquecido como .doc o .rtf.

- Paso 2. Define las reglas: escribe las reglas necesarias según las necesidades de tu sitio web. Ten mucho cuidado de producir bloqueos accidentales de contenido importante.

- Paso 3. Sube el archivo al servidor: el archivo robots.txt debe ubicarse en la raíz del dominio de tu web. Por ejemplo, si tu dominio es www.ejemplo.com, el archivo debe estar en www.ejemplo.com/robots.txt.

- Paso 4. Prueba el archivo: después de subir el archivo, utiliza la herramienta que proporciona Google Search Console para verificar que las reglas funcionan correctamente y no bloquean contenido que debería ser accesible.

Buenas Prácticas para el Uso de robots.txt

El archivo robots.txt es una herramienta fundamental para gestionar la forma en que los motores de búsqueda interactúan con tu sitio web. Un uso adecuado puede mejorar tu estrategia de SEO, mientras que los errores pueden impactar negativamente tu posicionamiento. A continuación, te detallo algunas buenas prácticas que puedes seguir para maximizar su efectividad:

1. No bloquees contenido importante

Trata de no bloquear páginas que son esenciales para la experiencia del usuario y para tu estrategia SEO, como páginas de productos, artículos de blog, categorías clave o la página de inicio. Revisa cuidadosamente las directrices de exclusión para asegurarte de que no estás limitando el acceso a contenido relevante que debería ser indexado.

Si has indexado alguna página por error no la bloquees aquí hasta asegurarte primero que Google ha leído de nuevo la url y la directiva no index

2. Evita el uso Excesivo de disallow

El uso indiscriminado de la directiva Disallow puede dificultar que los motores de búsqueda comprendan la estructura de tu sitio y clasifiquen tu contenido de manera efectiva. Bloquea solo aquellas páginas que no deseas que sean rastreadas, como archivos temporales, secciones privadas o duplicados de contenido.

3. Mantén el archivo actualizado

Tu archivo robots.txt debe evolucionar junto con tu sitio web. Cada vez que realices cambios en la estructura, añadas nuevas secciones o elimines páginas antiguas, actualiza el archivo para garantizar que sigue cumpliendo su función correctamente. Realiza revisiones periódicas para detectar errores o configuraciones obsoletas.

4. Utiliza comentarios para aclarar reglas

Añadir comentarios en el archivo robots.txt no solo facilita la colaboración con otros compañeros, también sirve como una guía para futuras actualizaciones. Los comentarios ayudan a explicar el propósito detrás de cada directiva, lo que reduce el riesgo de errores en la edición.

# Bloquear acceso a la carpeta de administración Disallow: /admin/

6. Permite el acceso a recursos necesarios

No bloquees archivos CSS, JavaScript o imágenes esenciales para la correcta visualización de tu web. Los motores de búsqueda necesitan acceder a estos recursos para renderizar y evaluar el contenido correctamente, lo que puede impactar en tu SEO.

7. Configura la ubicación del sitemap

Incluye en tu archivo robots.txt una referencia al sitemap de tu web para facilitar a los motores de búsqueda la localización de todas tus URLs

Sitemap: https://www.ejemplo.com/sitemap.xml 8. Revisa que todo esté bien con GSC

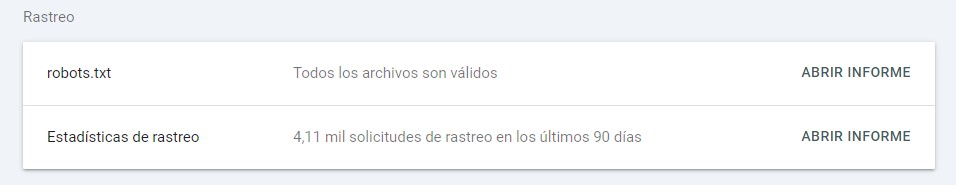

Ve a ajustes en tu propiedad de Google Search Console. En el apartado de Rastreo podrás ver si Google ha procesado el archivo robots y pinchando sobre él, podrás comprobar si tiene errores o está todo bien.

Esto te permitirá confirmar que las reglas funcionan como esperas y evitar errores críticos.

Errores comunes al usar robots.txt

Incluso con las mejores intenciones, es fácil cometer errores al configurar el archivo robots.txt.

- Bloquear accidentalmente todo el sitio: un error común es utilizar la directiva Disallow: /, lo que bloquea todo el sitio para todos los robots. Esto puede evitar que tu sitio aparezca en los resultados de búsqueda.

- Sintaxis Incorrecta: errores de sintaxis, como espacios adicionales o caracteres no permitidos, pueden hacer que ciertas reglas no funcionen como se espera.

- No especificar user-agent: olvidar especificar el User-agent puede llevar a que las reglas no se apliquen correctamente a los robots deseados.

- No incluir el sitemap: Omitir la ubicación del sitemap puede dificultar que los motores de búsqueda accedan a la estructura completa de tu sitio y no rastree algunas urls.

Si aun con nuestras explicaciones no sabes cómo implementar el archivo robots.txt de tu web en Seopedia Agencia SEO estaremos encantados de ayudarte, llámanos o mándanos un email